La virtualisation des capteurs est une application prometteuse de l’industrie 4.0. Grâce à l’intelligence artificielle, la méthode permet de s’affranchir de certaines contraintes et difficultés techniques associées à l’instrumentation des équipements, afin d’analyser et d’interpréter le fonctionnement d’un système en temps réel. Dans cet article, nous approfondirons l’application des capteurs virtuels par IA dans l’industrie aéronautique, en particulier pour la prédiction des contraintes mécaniques des avions.

1. Le Capteur Virtuel

Inscrite dans la démarche des jumeaux numériques, la virtualisation de capteurs est une application prometteuse de l’apprentissage machine pour l’analyse et la surveillance des systèmes industriels.

Imaginons un système industriel équipé de divers capteurs qui enregistrent en temps réel des grandeurs physiques (e.g. température, accélération, …) nous informant sur son état. Bien que se référant à des quantités différentes, mesurées à des positions différentes, ces variables sont liées entre elles par des relations physiques. La complexité du système associé à l’impossibilité de connaitre l’intégralité des variables explicatives peut rendre difficile la modélisation de ces relations par un modèle théorique. A la place, on peut s’en remettre à l’apprentissage machine pour apprendre à un algorithme à approximer les relations entre capteurs en se basant sur un historique de mesures. On appelle régression l’approche consistant à déterminer les valeurs d’une variable à partir d’autres variables, et cette méthode est à la base du capteur virtuel.

Il existe de nombreux intérêts à la virtualisation. On peut par exemple l’utiliser pour continuer à estimer une grandeur physique en cas de panne du capteur associé. Des logiques de coûts ou-bien de contraintes techniques peuvent aussi rendre difficile de placer des instruments dans certaines régions du système. On peut alors se servir des mesures indirectes fournies par les autres capteurs pour inférer la quantité d’intérêt et atténuer la zone d’ombre dans nos données. Au-delà de la reconstruction d’une information physique, il est également possible de calibrer le capteur virtuel pour retourner d’autres valeurs comme par exemple un score de normalité permettant de nous informer sur l’état de santé du système et de détecter et/ou d’anticiper d’éventuelles anomalies.

2. Cas d’étude : Contraintes mécaniques subies par un avion

Nous proposons ici d’illustrer l’application du capteur virtuel au travers du suivit de la fatigue mécanique accumulée par un avion. Chaque avion possède un certain nombre de capteurs fonctionnels nécessaire à la navigation et au pilotage (altitude, vitesses, masses réservoirs, …). Dans le cadre d’une campagne de tests, certains avions ont en plus été équipés de jauges afin de mesurer les contraintes et déformations subies au niveau du fuselage et des ailes. Ces informations sont précieuses pour quantifier les efforts cumulés appliqués au cours du temps sur la structure et renseigner sur l’état de fatigue de l’appareil. Cependant les jauges sont difficiles à mettre en place et requières une forte maintenance ce qui rend la mesure directe non praticable pour les avions commerciaux.

L’objectif est donc ici de créer un algorithme qui permette de prédire les valeurs de contraintes et déformations telles qu’elles seraient mesurées par les jauges en se servant uniquement des données enregistrées par les capteurs fonctionnels.

3. Timeflow et Carte Dédiée

La solution Timeflow, développée par Aquila, implémente les briques algorithmiques nécessaires pour créer et déployer un capteur virtuel.

Figure 1 : Notre solution TimeFlow

En collaboration avec les ingénieurs de vol et les mécaniciens, nous avons construit une carte Timeflow sous forme d’un workflow intégrant le prétraitement et la sélection des données, le feature engineering, la modélisation, le monitoring et la validation des résultats. Chaque brique algorithmique est adaptée en prenant en compte les spécificités du problème et les hyperparamètres sont réglés sous le contrôle des experts métiers.

3.1. Modèle

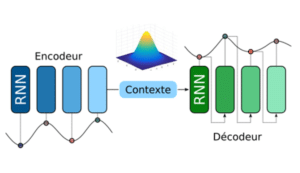

Figure 2 : Architecture schématique de l’auto-encodeur variationnel

Au cœur du workflow se trouve le modèle utilisé pour modéliser le capteur virtuel. Nous nous sommes basés sur un réseau de neurone (NN) de la famille des auto-encodeur variationnels (VAE) [1], entraîné par apprentissage profond. Le modèle fonctionne en deux étapes. Un premier réseau, l’encodeur, transforme et compresse les données des capteurs fonctionnels dans un espace réduit appelé espace latent. Un deuxième réseau, le décodeur, décompresse les données afin de recréer les déformations telles qu’elles auraient été mesurées par les jauges. L’espace latent est formalisé de façon probabiliste, en étant associé à une distribution de probabilité, en générale une distribution Gaussienne isotrope.

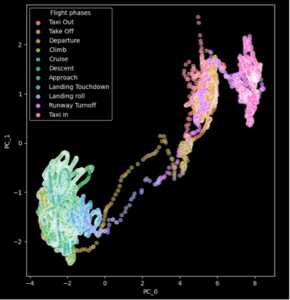

Figure 3 : Projection en 2D des variables latentes associées à un vol. L’échelle de couleur correspond aux différentes phases de vol.

Dans cette configuration, le décodeur tire aléatoirement un vecteur de la distribution d’après les paramètres calculés par l’encodeur. Cette approche sert de régularisation mathématique au problème d’optimisation et permet d’augmenter les chances d’obtenir un espace qui soit interprétable. Dans la Figure 3 on visualise la projection en deux dimensions (par Analyse en Composants Principaux) des variables latentes associées à un vol complet du décollage à l’atterrissage. Bien que les différentes phases de vols n’aient pas été explicitement données en entrée du model, on peut voir que l’espace latent s’est naturellement structuré en regroupant dans les mêmes régions des points de vols similaires et en créant des chemins pour passer d’une phase à l’autre.

Nous nous sommes arrêtés sur ce choix car les VAE possèdent un certain nombre propriétés intéressantes. Premièrement, les réseaux de neurones étant entièrement modulaires il est possible d’adapter l’architecture aux données, par exemple en utilisant des mécanismes de récurrence ou-bien d’attention afin de prendre en compte la nature dynamique des séries temporelles. Les NN sont également compatibles avec toute opération différentiable et il est donc possible d’inscrire des lois physiques exprimées sous formes d’équation différentielles directement dans l’architecture ou-bien dans la fonction d’apprentissage [2]. Ces modèles supportent également très bien le multivarié (on peut reconstruire plusieurs capteurs à la fois) et sont adaptés pour apprendre à partir d’une grande quantité de données.

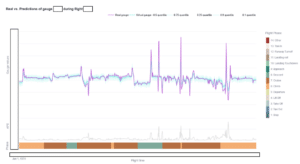

Dans la Figure 4, on montre un exemple de reconstitution d’une jauge virtuelle (en bleu) comparée à la jauge réelle en violet.

Figure 4 : Comparaison entre la déformation réelle mesurée par une jauge (violet) et la déformation virtuelle calculée par notre modèle (bleu)

3.2. Anomalies

En plus de la simulation des jauges, le modèle fournit également des indicateurs qui peuvent nous aider à interpréter les résultats et à détecter des valeurs anormales dans les données.

Nous utilisons une fonction d’apprentissage dite “quantile” afin de déterminer l’exactitude des valeurs de déformations prédites [3]. Cette approche permet de prédire la valeur médiane ainsi que les valeurs quantiles et donne une idée sur la dispersion des valeurs possibles de déformation. Dans la Figure 3, nous avons reporté la valeur médiane de la jauge ainsi que les quantiles q0.1, q0.25, q0.75 et q0.9. En calculant la distance inter-quantile pour chaque point de la prédiction, on crée une série temporelle qui sert d’indicateur de confiance du modèle. Une large distance inter-quantile indique qu’il est possible qu’il y ait une large erreur dans la valeur prédite.

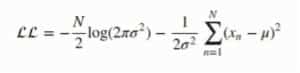

L’espace latent du VAE ayant été contraint pour suivre une distribution Gaussienne isotrope, on peut calculer, selon l’Equation 1, la vraisemblance associée à chaque vecteur. On forme ainsi une série temporelle fournissant un indicateur supplémentaire. Une faible vraisemblance indique que les données d’entrées sont inhabituelles par apport à celles observées pendant l’entraînement.

4. Validation et Perspectives

Une fois le modèle entraîné et les chaînes de pré et post traitements mises en place, il est important de consacrer du temps à analyser et valider les résultats, en se reposant notamment sur l’expertise des ingénieurs qui travaillent tous les jours avec ces données.

En plus de calculer des métriques globales pour obtenir une information sur l’exactitude, en moyenne, des jauges virtuelles, il faut également analyser les erreurs dans le détail afin de comprendre les limites du modèle. On souhaite par exemple savoir si la reconstruction est de qualité similaire pour toutes les phases de vols ou-bien si des événements perturbateurs comme les turbulences ou les rafales de vent ont un effet sur la justesse des prédictions.

Les deux méthodes présentées ici pour construire des indicateurs d’anomalies sont basées sur une approche non-supervisée. Cette propriété est importante car il est rare dans l’industrie de disposer d’une quantité exhaustive d’information sur tous les événements observées dans les données. Cependant, afin d’être interprétable, il est nécessaire d’analyser et de calibrer ces scores. En effet, une anomalies telle que détectée par les indicateurs peut avoir de nombreuses causes possibles comme par exemple la défaillance d’un capteur ou-bien la survenue d’un événement statistiquement rare. Afin de faciliter ces étapes, nous avons mis en place dans Timeflow un tableau de bord (dashboard) interactif et personnalisable afin de pouvoir facilement naviguer dans les données. A terme, des fonctionna lités de labélisation manuelle seront également intégrées afin d’enrichir la base de données et ainsi pouvoir se servir de notre module de caractérisation des anomalies basé sur une taxonomie métier.

Figure 5 : Notre tableau de bord développé pour la gestion des modèles et la visualisation des données.

Enfin, dans le cadre d’une thèse Cifre, nous nous intéressons aux différentes approches possibles afin d’incorporer de la physique dans la modélisation, notamment en ayant recours aux réseaux de neurones informés par la physique (PINNs) [https://www.youtube.com/watch?v=NTW9venPerU]. Ces approches sont intéressantes puisqu’elles permettent d’apporter des garanties théoriques sur la fiabilité du capteur virtuel développé, là où les approches purement basées sur l’assimilation de données n’offrent que des garanties empiriques.

Cette étude constitue le premier pas dans l’utilisation d’une technologie innovante pour apporter des améliorations en termes de conception, de test et de maintenance des aéronefs, avec à terme l’objectif de contribuer à accroître la sécurité, les performances et la durabilité des avions.